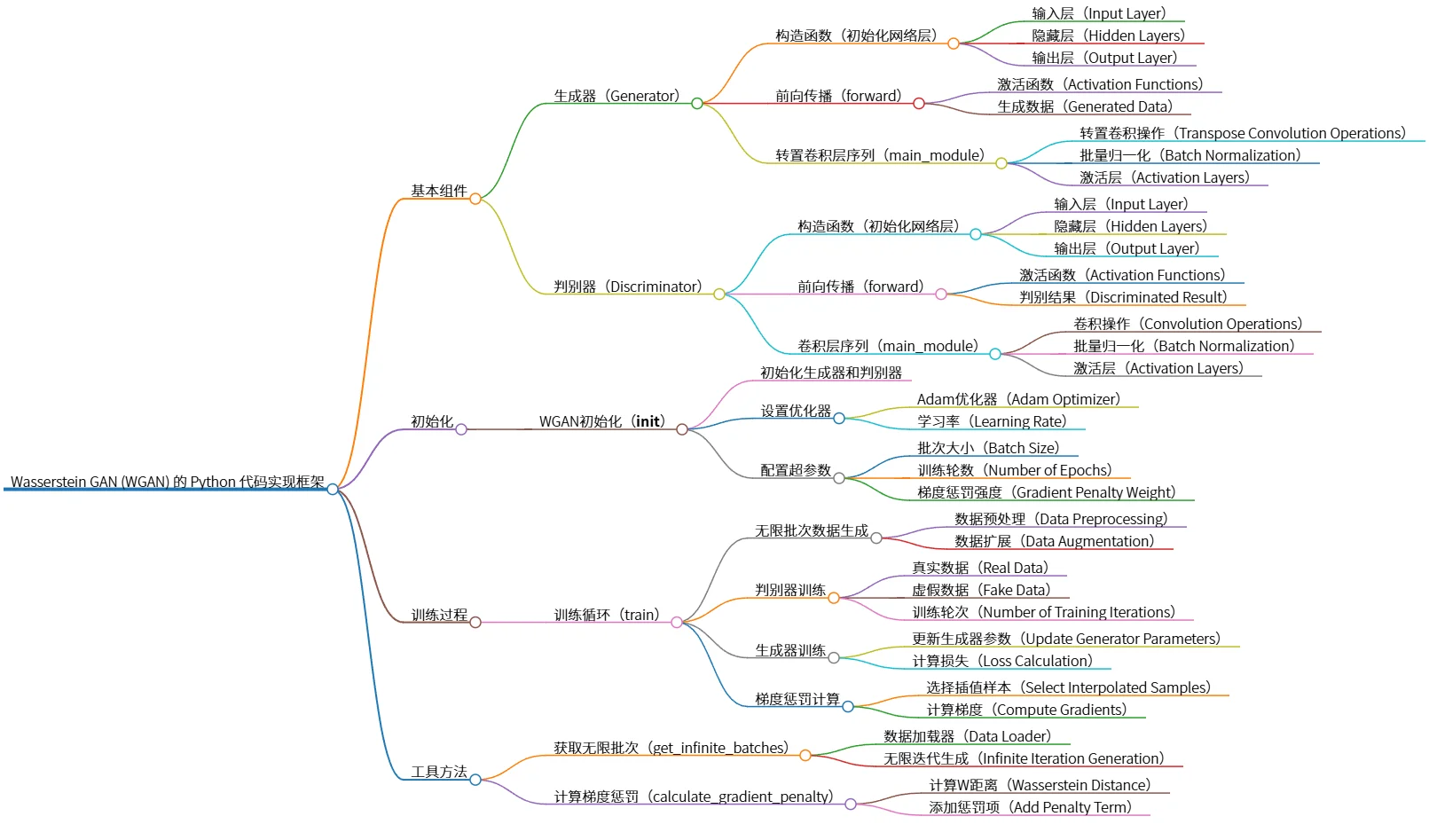

Wasserstein GAN (WGAN) 的 Python 代码实现框架

该思维导图概述了Wasserstein GAN (WGAN) 的核心组件、初始化过程和训练流程。WGAN 包含生成器(包含转置卷积层)和判别器(包含卷积层),两者均需初始化并配置优化器。训练过程涉及无限批次数据生成,判别器和生成器的交替训练,以及关键的梯度惩罚计算以增强训练稳定性。 辅助方法包括获取无限批次数据和计算梯度惩罚。 该图清晰地展现了WGAN模型的结构和训练步骤。

源码

# Wasserstein GAN (WGAN) 的 Python 代码实现框架

## 基本组件

- 生成器(Generator)

- 构造函数(初始化网络层)

- 输入层(Input Layer)

- 隐藏层(Hidden Layers)

- 输出层(Output Layer)

- 前向传播(forward)

- 激活函数(Activation Functions)

- 生成数据(Generated Data)

- 转置卷积层序列(main_module)

- 转置卷积操作(Transpose Convolution Operations)

- 批量归一化(Batch Normalization)

- 激活层(Activation Layers)

- 判别器(Discriminator)

- 构造函数(初始化网络层)

- 输入层(Input Layer)

- 隐藏层(Hidden Layers)

- 输出层(Output Layer)

- 前向传播(forward)

- 激活函数(Activation Functions)

- 判别结果(Discriminated Result)

- 卷积层序列(main_module)

- 卷积操作(Convolution Operations)

- 批量归一化(Batch Normalization)

- 激活层(Activation Layers)

## 初始化

- WGAN初始化(__init__)

- 初始化生成器和判别器

- 设置优化器

- Adam优化器(Adam Optimizer)

- 学习率(Learning Rate)

- 配置超参数

- 批次大小(Batch Size)

- 训练轮数(Number of Epochs)

- 梯度惩罚强度(Gradient Penalty Weight)

## 训练过程

- 训练循环(train)

- 无限批次数据生成

- 数据预处理(Data Preprocessing)

- 数据扩展(Data Augmentation)

- 判别器训练

- 真实数据(Real Data)

- 虚假数据(Fake Data)

- 训练轮次(Number of Training Iterations)

- 生成器训练

- 更新生成器参数(Update Generator Parameters)

- 计算损失(Loss Calculation)

- 梯度惩罚计算

- 选择插值样本(Select Interpolated Samples)

- 计算梯度(Compute Gradients)

## 工具方法

- 获取无限批次(get_infinite_batches)

- 数据加载器(Data Loader)

- 无限迭代生成(Infinite Iteration Generation)

- 计算梯度惩罚(calculate_gradient_penalty)

- 计算W距离(Wasserstein Distance)

- 添加惩罚项(Add Penalty Term)

图片